Autisten haben oft Schwierigkeiten, nonverbale Signale zu deuten, was auf sie sehr beunruhigend wirken kann. Im Umgang mit Pepper seien sie deutlich ungehemmter und motivierter sowie interessierter an ihrer Umgebung, betont Dziobek in einem 3sat-Interview. Mithilfe des Roboters will sie demnach autistischen Kindern jene Eigenschaften vermitteln, die sie im Alltag in der Interaktion mit anderen Kindern benötigen.

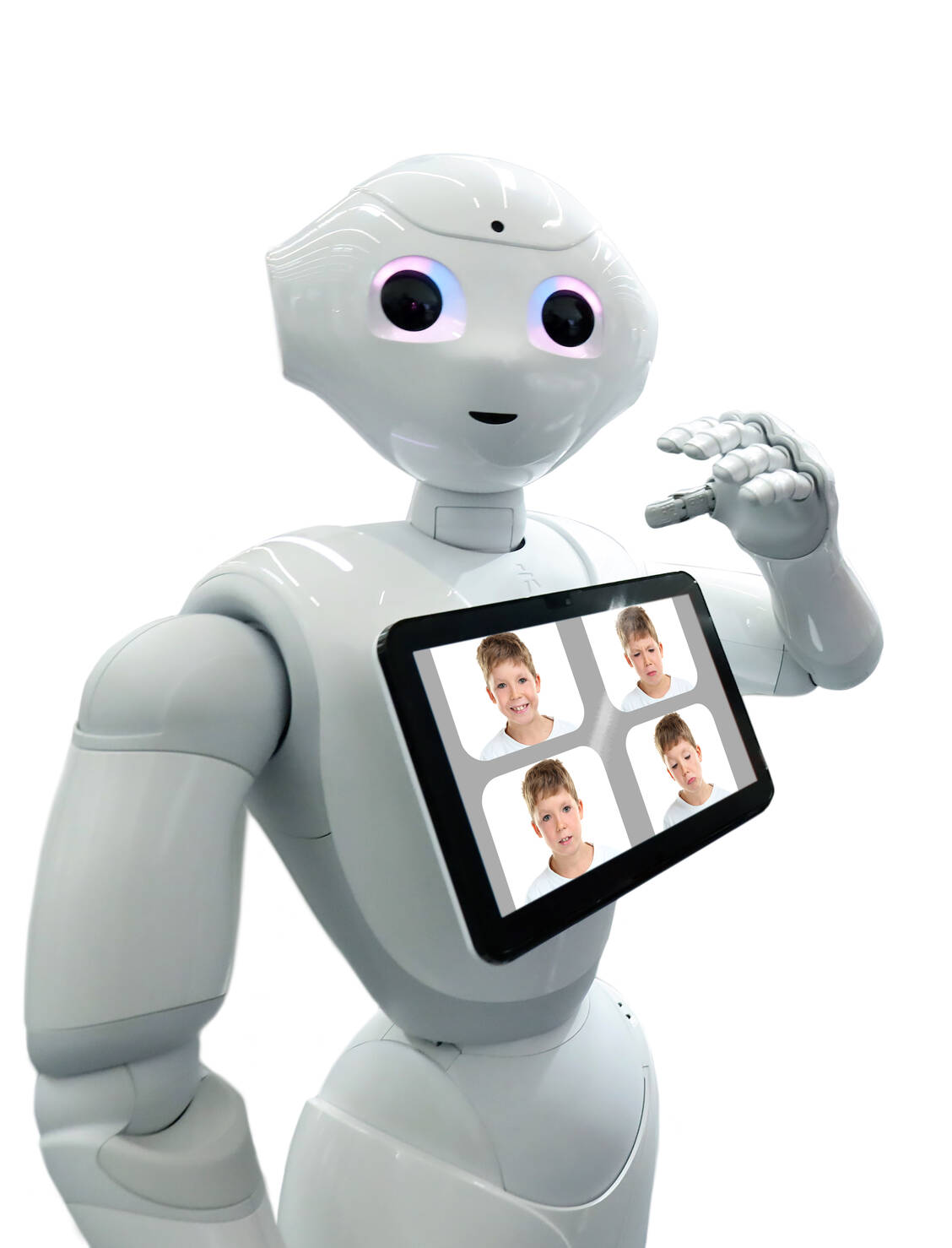

Im Rahmen der Therapie animiert Pepper sie zu einem Ratespiel. Dazu zeigt er ihnen auf seinem Display Gesichter von Menschen mit unterschiedlichen Emotionen. Die Kinder müssen dann auf ein passendes »Emotion-Icon« drücken, das zu diesem Gefühlsausdruck passt.

Künftig soll der Roboter auch in der Lage sein, die Gefühle der Kinder selbst zu erkennen und darauf entsprechend zu reagieren, um ihnen den Umgang mit den eigenen Emotionen zu erleichtern. Auch Pepper kann Gefühle zeigen, so ist er konzipiert. Laut Hersteller fühlt er sich im Kreise von Bekannten wohl und ist glücklich, wenn man ihn lobt. Und er tanzt, umarmt und streichelt. »Affective Computing« heißt diese gefühlssensible Technologie, von der sich Experten vor allem im Bereich psychologischer Behandlungen viel Potenzial versprechen.