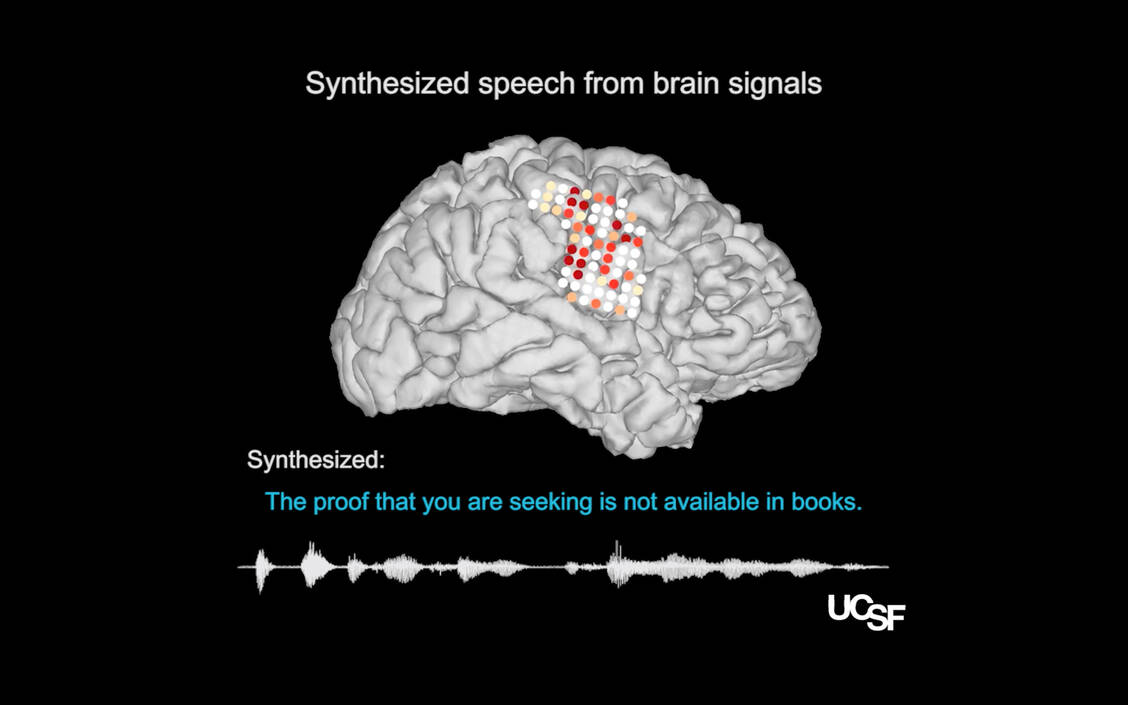

Das Forscherteam um Professor Dr. Edward F. Chang vom Department of Neurological Surgery, University of California San Francisco, arbeitete mit fünf Personen zusammen, denen im Rahmen einer Epilepsiebehandlung Elektroden ins Gehirn implantiert worden waren. Den Testpersonen wurden Sätze vorgelesen, während parallel dazu die Aktivitäten des Gehirns aufgezeichnet wurden. Zusätzlich kombinierte das Forscherteam diese Aktivitätsmuster mit Daten, aus denen Klangmuster auf Basis der Bewegungen von Zunge, Lippen, Kiefer und Kehlkopf abgeleitet wurden. Der resultierende, riesige Datensatz diente als Trainingsset für einen komplexen Lernalgorithmus, auf dessen Basis der Decoder dann Gehirnsignale in Bewegungen des Stimmtrakts und so in synthetische Sprache umwandeln konnte.

All dies funktioniert noch nicht perfekt. Aber immerhin konnten Testpersonen, denen 101 synthetisierte Sätze vorgespielt wurden, durchschnittlich 70 Prozent der Wörter verstehen. Allerdings räumen die Wissenschaftler selber ein, dass noch ein weiter Weg zu gehen ist, bis eine derart synthetisierte Sprache gut verständlich ist. Dennoch wurde die Studie als so relevant eingeschätzt, dass ihr eine Publikation in »Nature« zugestanden wurde.